高性能 AI 计算领域的先驱Cerebras Systems推出了一项突破性的解决方案,旨在彻底改变 AI 推理。2024 年 8 月 27 日,该公司宣布推出世界上最快的 AI 推理服务 Cerebras Inference。Cerebras Inference 的性能指标远超传统的基于 GPU 的系统,速度提高了 20 倍,成本却只有后者的一小部分,为 AI 计算树立了新的标杆。

前所未有的速度和成本效率

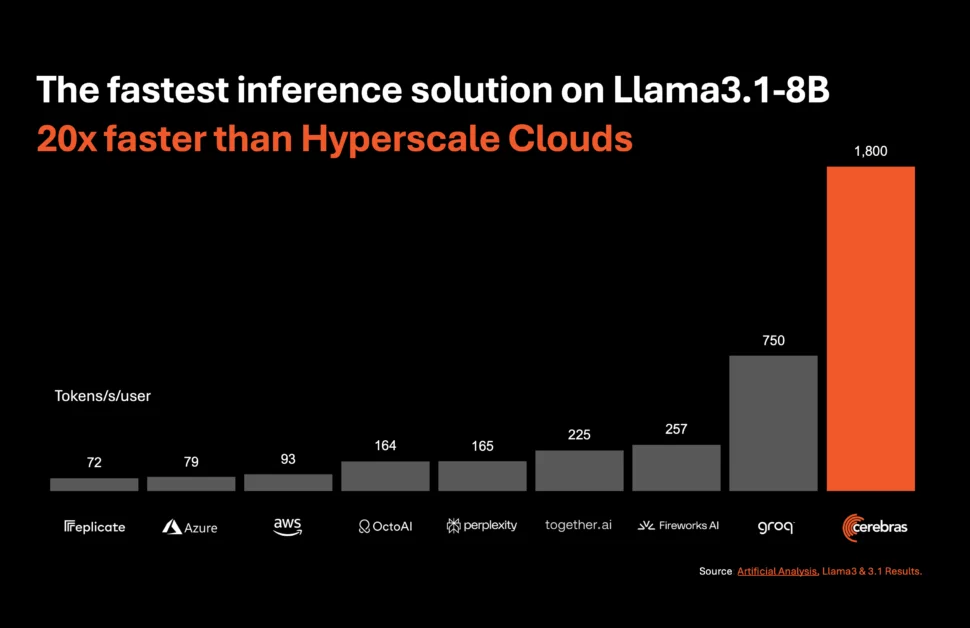

Cerebras Inference 旨在为各种 AI 模型提供卓越的性能,特别是在快速发展的大型语言模型(LLM) 领域。例如,它每秒处理 1,800 个令牌(Llama 3.1 8B 模型)和 450 个令牌(Llama 3.1 70B 模型)。这种性能不仅比基于 NVIDIA GPU 的解决方案快 20 倍,而且成本也低得多。Cerebras 为 Llama 3.1 8B 模型提供这项服务的起价仅为每百万令牌 10 美分,为 Llama 3.1 70B 模型提供这项服务的起价仅为每百万令牌 60 美分,与现有的基于 GPU 的产品相比,性价比提高了 100 倍。

保持准确性的同时突破速度界限

Cerebras Inference 最令人印象深刻的方面之一是它能够在提供无与伦比的速度的同时保持最先进的准确性。与其他为了速度而牺牲精度的方法不同,Cerebras 的解决方案在整个推理过程中都保持在 16 位域内。这确保了性能提升不会以牺牲 AI 模型输出的质量为代价,这对于专注于精度的开发人员来说是一个关键因素。

Artificial Analysis 联合创始人兼首席执行官 Micah Hill-Smith 强调了这一成就的重要性:“对于 Meta 的 Llama 3.1 8B 和 70B AI 模型,Cerebras 的速度比基于 GPU 的解决方案快一个数量级。我们在 Llama 3.1 8B 上测量到每秒输出令牌超过 1,800 个,在 Llama 3.1 70B 上测量到每秒输出令牌超过 446 个——这些基准测试中创下了新纪录。”

人工智能推理的重要性日益增加

AI 推理是 AI 计算中增长最快的部分,约占整个 AI 硬件市场的 40%。高速 AI 推理(例如 Cerebras 提供的推理)的出现类似于宽带互联网的引入——为 AI 应用释放了新机遇并开启了新时代。借助 Cerebras Inference,开发人员现在可以构建需要复杂实时性能的下一代 AI 应用程序,例如 AI 代理和智能系统。

DeepLearning.AI 创始人 Andrew Ng 强调了速度在 AI 开发中的重要性:“ DeepLearning.AI 有多个代理工作流程,需要反复提示 LLM 才能获得结果。Cerebras 已经建立了令人印象深刻的快速推理能力,这对此类工作负载非常有帮助。 ”

广泛的行业支持和战略合作伙伴关系

Cerebras 获得了行业领导者的大力支持,并建立了战略合作伙伴关系,以加速 AI 应用的开发。Cerebras 的早期客户葛兰素史克的 AI/ML 高级副总裁 Kim Branson 强调了这项技术的变革潜力:“速度和规模改变了一切。”

LiveKit、 Perplexity和 Meter等其他公司也对 Cerebras Inference 对其运营的影响表现出极大的热情。这些公司正在利用 Cerebras 的强大计算能力来创造响应更快、更人性化的 AI 体验,改善搜索引擎中的用户交互,并增强网络管理系统。

Cerebras 推理:层级和可访问性

Cerebras Inference 提供三个价格极具竞争力的层级:免费层级、开发者层级和企业层级。免费层级提供免费的 API 访问,且使用限制宽松,因此可供广大用户使用。开发者层级提供灵活的无服务器部署选项,Llama 3.1 模型的价格为每百万个代币 10 美分和 60 美分。企业层级适合具有持续工作负载的组织,提供经过微调的模型、定制的服务级别协议和专门的支持,价格可根据要求提供。

为 Cerebras 推理提供动力:晶圆级引擎 3 (WSE-3)

Cerebras Inference 的核心是 Cerebras CS-3 系统,该系统由业界领先的 Wafer Scale Engine 3 (WSE-3) 提供支持。这款 AI 处理器在尺寸和速度方面无与伦比,内存带宽比 NVIDIA 的 H100 多 7,000 倍。WSE-3 的庞大规模使其能够处理许多并发用户,确保极快的速度而不影响性能。这种架构使 Cerebras 能够避开通常困扰基于 GPU 的系统的各种权衡,为 AI 工作负载提供一流的性能。

无缝集成和开发人员友好的 API

Cerebras Inference 的设计充分考虑了开发人员的需求。它具有与 OpenAI Chat Completions API 完全兼容的 API,只需进行少量代码更改即可轻松迁移。这种开发人员友好型方法可确保将 Cerebras Inference 尽可能无缝地集成到现有工作流程中,从而实现高性能 AI 应用程序的快速部署。

Cerebras Systems:推动跨行业创新

Cerebras Systems 不仅是 AI 计算领域的领导者,也是医疗保健、能源、政府、科学计算和金融服务等各个行业的重要参与者。该公司的解决方案在推动国家实验室、Aleph Alpha、梅奥诊所和葛兰素史克等机构取得突破方面发挥了重要作用。

通过提供无与伦比的速度、可扩展性和准确性,Cerebras 使这些行业的组织能够解决 AI 及其他领域中一些最具挑战性的问题。无论是加速医疗保健领域的药物研发,还是增强科学研究中的计算能力,Cerebras 都处于推动创新的前沿。

结论:人工智能推理的新时代

Cerebras Systems 推出 Cerebras Inference,为 AI 推理树立了新标准。Cerebras 以极低的成本提供传统 GPU 系统 20 倍的速度,不仅让 AI 更加普及,还为下一代 AI 应用铺平了道路。凭借其尖端技术、战略合作伙伴关系和对创新的承诺,Cerebras 有望引领 AI 行业进入前所未有的性能和可扩展性的新时代。

有关 Cerebras Systems 的更多信息以及尝试 Cerebras Inference,请访问www.cerebras.ai。

原创文章,作者:AI评测师,如若转载,请注明出处:https://www.dian8dian.com/cerebras-tui-chu-quan-qiu-zui-kuai-de-ai-tui-li-jie-jue